قامت OpenAI، الشركة المصنعة لـ ChatGPT، بتغيير قواعدها بهدوء وإزالة الحظر المفروض على استخدام chatbot وأدوات الذكاء الاصطناعي الأخرى للأغراض العسكرية – وكشفت أنها تعمل بالفعل مع وزارة الدفاع.

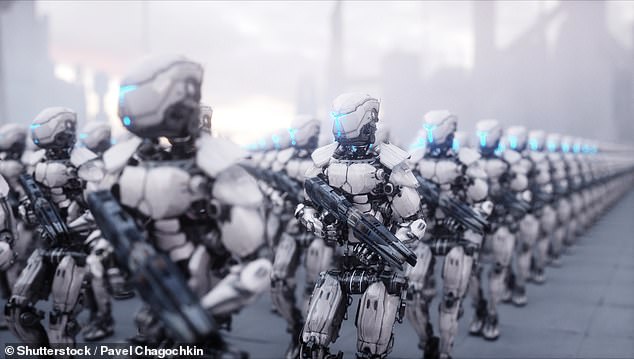

وسبق أن أعرب الخبراء عن مخاوفهم من أن الذكاء الاصطناعي قد يؤدي إلى تصعيد الصراعات في جميع أنحاء العالم بفضل “الروبوتات” التي يمكن أن تقتل دون أي تدخل بشري.

أدى تغيير القاعدة، الذي حدث بعد يوم الأربعاء من الأسبوع الماضي، إلى إزالة الجملة التي تنص على أن الشركة لن تسمح باستخدام النماذج في “الأنشطة التي تنطوي على مخاطر عالية للأذى الجسدي، بما في ذلك: تطوير الأسلحة والجيش والحرب”.

صرح متحدث باسم OpenAI لموقع DailyMail.com أن الشركة، التي تجري محادثات لجمع الأموال بقيمة 100 مليار دولار، تعمل مع وزارة الدفاع على أدوات الأمن السيبراني المصممة لحماية البرمجيات مفتوحة المصدر.

قامت OpenAI، الشركة المصنعة لـ ChatGPT، بتغيير قواعدها بهدوء وإزالة الحظر المفروض على استخدام chatbot وأدوات الذكاء الاصطناعي الأخرى للأغراض العسكرية (صورة مخزنة)

وقال المتحدث: “سياستنا لا تسمح باستخدام أدواتنا لإيذاء الناس، أو تطوير الأسلحة، أو مراقبة الاتصالات، أو إصابة الآخرين أو تدمير الممتلكات”.

“ومع ذلك، هناك حالات استخدام تتعلق بالأمن القومي تتوافق مع مهمتنا.

“على سبيل المثال، نحن نعمل بالفعل مع وكالة مشاريع الأبحاث الدفاعية المتقدمة (DARPA) لتحفيز إنشاء أدوات جديدة للأمن السيبراني لتأمين البرامج مفتوحة المصدر التي تعتمد عليها البنية التحتية الحيوية والصناعة.

“لم يكن من الواضح ما إذا كان سيتم السماح بحالات الاستخدام المفيد هذه بموجب مصطلح “عسكري” في سياساتنا السابقة.” لذا فإن الهدف من تحديث سياستنا هو توفير الوضوح والقدرة على إجراء هذه المناقشات.

في العام الماضي، وقعت 60 دولة، بما في ذلك الولايات المتحدة والصين، على “دعوة للعمل” للحد من استخدام الذكاء الاصطناعي (AI) لأسباب عسكرية.

وأشار خبراء حقوق الإنسان في لاهاي إلى أن “الدعوة إلى العمل” ليست ملزمة قانونًا ولم تعالج المخاوف بما في ذلك طائرات بدون طيار قاتلة تعمل بالذكاء الاصطناعي أو أن الذكاء الاصطناعي يمكن أن يؤدي إلى تصعيد الصراعات القائمة.

وقال الموقعون إنهم ملتزمون بتطوير واستخدام الذكاء الاصطناعي العسكري وفقًا “للالتزامات القانونية الدولية وبطريقة لا تقوض الأمن الدولي والاستقرار والمساءلة”.

استخدمت أوكرانيا أنظمة التعرف على الوجه وأنظمة الاستهداف المدعومة بالذكاء الاصطناعي في معركتها مع روسيا.

وفي عام 2020، أطلقت القوات الحكومية الليبية طائرة تركية بدون طيار من طراز كارغو-2 هاجمت الجنود المتمردين المنسحبين، وهو أول هجوم من نوعه في التاريخ، وفقًا لتقرير للأمم المتحدة.

وقال تقرير الأمم المتحدة إن الطائرة القاتلة بدون طيار تمت برمجتها للهجوم “دون الحاجة إلى اتصال بيانات بين المشغل والذخيرة: في الواقع، إنها قدرة حقيقية على إطلاق النار والنسيان والعثور”.

وقالت آنا ماكانجو، نائبة رئيس الشؤون العالمية في OpenAI، في مقابلة هذا الأسبوع إنه تمت إزالة البند “الشامل” للسماح بحالات الاستخدام العسكري التي توافق عليها الشركة.

وقال ماكانجو لبلومبرج: “لأننا في السابق كان لدينا ما كان في الأساس حظرًا شاملاً على الجيش، اعتقد الكثير من الناس أن ذلك سيحظر العديد من حالات الاستخدام هذه، والتي يعتقد الناس أنها تتوافق إلى حد كبير مع ما نريد رؤيته في العالم”.

سام ألتمان من OpenAI يتحدث في دافوس (غيتي)

أثار استخدام الذكاء الاصطناعي لأغراض عسكرية من قبل منظمات “Big Tech” جدلاً في السابق.

وفي عام 2018، احتج الآلاف من موظفي جوجل على عقد البنتاغون – Project Maven – الذي شهد استخدام أدوات الذكاء الاصطناعي الخاصة بالشركة لتحليل لقطات مراقبة الطائرات بدون طيار.

وفي أعقاب الاحتجاجات، لم تجدد جوجل العقد.

احتج موظفو شركة مايكروسوفت على عقد بقيمة 480 مليون دولار لتزويد الجنود بسماعات الواقع المعزز.

في عام 2017، كتب قادة التكنولوجيا، بما في ذلك إيلون ماسك، إلى الأمم المتحدة يطالبون فيها بحظر الأسلحة المستقلة، بموجب قوانين مشابهة لتلك التي تحظر الأسلحة الكيميائية وأشعة الليزر المصممة للمكفوفين.

وحذرت المجموعة من أن الأسلحة المستقلة تهدد ببدء “ثورة ثالثة في الحرب”: الأولين هما البارود والأسلحة النووية.

وحذر الخبراء من أنه بمجرد فتح “صندوق باندورا” للأسلحة المستقلة بالكامل، فقد يكون من المستحيل إغلاقه مرة أخرى.

اترك ردك