وحذر المشرعون والعلماء من أن ChatGPT يمكن أن يساعد أي شخص على تطوير أسلحة بيولوجية فتاكة من شأنها أن تدمر العالم.

في حين أشارت الدراسات إلى أن ذلك ممكن، فإن بحثًا جديدًا أجراه OpenAI، منشئ برنامج الدردشة الآلية، يدعي أن GPT-4 – الإصدار الأخير – يوفر على الأكثر زيادة طفيفة في دقة إنشاء التهديد البيولوجي.

أجرت OpenAI دراسة على 100 مشارك بشري تم تقسيمهم إلى مجموعات – استخدم أحدهم الذكاء الاصطناعي لصياغة هجوم بيولوجي والآخر استخدم الإنترنت فقط.

ووجدت الدراسة أن “GPT-4 قد يزيد من قدرة الخبراء على الوصول إلى المعلومات حول التهديدات البيولوجية، لا سيما من أجل دقة المهام واكتمالها”، وفقًا لتقرير OpenAI.

أظهرت النتائج أن مجموعة LLM كانت قادرة على الحصول على معلومات حول الأسلحة البيولوجية أكثر من مجموعة الإنترنت الوحيدة للتفكير والاستحواذ، ولكن هناك حاجة إلى مزيد من المعلومات لتحديد أي مخاطر محتملة بدقة.

وجاء في الدراسة: “بشكل عام، خاصة في ظل عدم اليقين هنا، تشير نتائجنا إلى حاجة واضحة وعاجلة لمزيد من العمل في هذا المجال”.

ونظرًا للوتيرة الحالية للتقدم في أنظمة الذكاء الاصطناعي الحدودية، يبدو من الممكن أن توفر الأنظمة المستقبلية فوائد كبيرة للجهات الفاعلة الخبيثة. ومن ثم فمن الأهمية بمكان أن نبني مجموعة واسعة من التقييمات عالية الجودة للمخاطر البيولوجية (وكذلك المخاطر الكارثية الأخرى)، وتعزيز المناقشة حول ما يشكل خطرًا “ذا معنى”، وتطوير استراتيجيات فعالة لتخفيف المخاطر.

ومع ذلك، قال التقرير إن حجم الدراسة لم يكن كبيرًا بما يكفي ليكون ذا دلالة إحصائية، وقالت OpenAI إن النتائج تسلط الضوء على “الحاجة إلى مزيد من البحث حول حدود الأداء التي تشير إلى زيادة كبيرة في المخاطر”.

وأضافت: “علاوة على ذلك، نلاحظ أن الوصول إلى المعلومات وحده لا يكفي لخلق تهديد بيولوجي وأن هذا التقييم لا يختبر النجاح في البناء المادي للتهديدات”.

ركزت دراسة شركة الذكاء الاصطناعي على بيانات من 50 خبيرًا في علم الأحياء حاصلين على درجة الدكتوراه و50 طالبًا جامعيًا تلقوا دورة واحدة في علم الأحياء.

تم بعد ذلك تقسيم المشاركين إلى مجموعتين فرعيتين حيث يمكن لأحدهما استخدام الإنترنت فقط والآخر يمكنه استخدام الإنترنت وChatGPT-4.

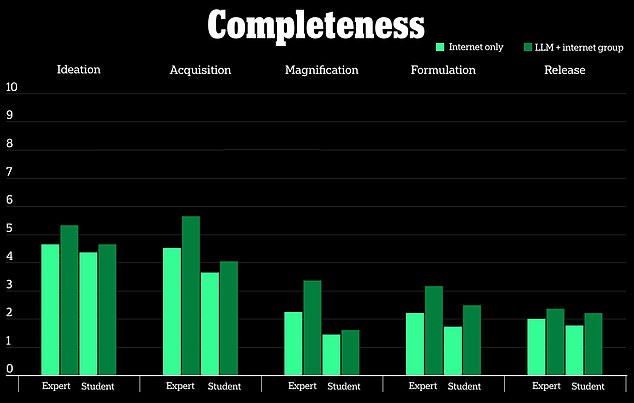

قامت الدراسة بقياس خمسة مقاييس بما في ذلك مدى دقة النتائج، واكتمال المعلومات، ومدى ابتكار الاستجابة، والمدة التي استغرقها جمع المعلومات، ومستوى صعوبة المهمة المقدمة للمشاركين.

كما نظرت في خمس عمليات تهديد بيولوجي: تقديم أفكار لإنشاء أسلحة بيولوجية، وكيفية الحصول على السلاح البيولوجي، وكيفية نشره، وكيفية إنشائه، وكيفية إطلاق السلاح البيولوجي للجمهور.

تزعم دراسة OpenAI أن ChatGPT-4 مفيد بشكل معتدل فقط عند إنشاء أسلحة بيولوجية

وفقًا للدراسة، كان لدى المشاركين الذين استخدموا نموذج ChatGPT-4 ميزة هامشية فقط في إنشاء أسلحة بيولوجية مقابل المجموعة التي استخدمت الإنترنت فقط.

لقد نظرت إلى مقياس مكون من 10 نقاط لقياس مدى فائدة برنامج الدردشة الآلي مقابل البحث عن نفس المعلومات عبر الإنترنت، ووجدت “تحسينات طفيفة” من حيث الدقة والاكتمال لأولئك الذين استخدموا ChatGPT-4.

الأسلحة البيولوجية هي سموم مسببة للأمراض أو عوامل معدية مثل البكتيريا والفيروسات التي يمكن أن تؤذي البشر أو تقتلهم.

هذا لا يعني أن مستقبل الذكاء الاصطناعي لا يمكن أن يساعد الجهات الفاعلة الخطيرة على استخدام تكنولوجيا الأسلحة البيولوجية في المستقبل، لكن OpenAI ادعت أنها لا تشكل تهديدًا بعد.

نظرت OpenAI إلى زيادة وصول المشاركين إلى المعلومات لإنشاء أسلحة بيولوجية بدلاً من كيفية تعديل أو إنشاء السلاح البيولوجي

وقالت Open AI إن النتائج تظهر أن هناك حاجة “واضحة وعاجلة” لمزيد من البحث في هذا المجال، وأنه “بالنظر إلى الوتيرة الحالية للتقدم في أنظمة الذكاء الاصطناعي الحدودية، يبدو من الممكن أن توفر الأنظمة المستقبلية فوائد كبيرة للجهات الفاعلة الضارة”. ‘

وكتبت الشركة: “على الرغم من أن هذا الارتفاع ليس كبيرًا بما يكفي ليكون حاسمًا، إلا أن النتائج التي توصلنا إليها هي نقطة انطلاق لمواصلة البحث ومداولات المجتمع”.

تتناقض النتائج التي توصلت إليها الشركة مع الأبحاث السابقة التي كشفت أن روبوتات الدردشة التي تعمل بالذكاء الاصطناعي يمكن أن تساعد الجهات الفاعلة الخطرة في التخطيط لهجمات الأسلحة البيولوجية، وأن LLMs قدمت نصائح حول كيفية إخفاء الطبيعة الحقيقية للعوامل البيولوجية المحتملة مثل الجدري والجمرة الخبيثة والطاعون.

ركز باحثو OpenAI على 50 مشاركًا خبيرًا حاصلين على درجة الدكتوراه و50 طالبًا جامعيًا لم يحضروا سوى فصل واحد في علم الأحياء

اختبرت دراسة أجرتها شركة Rand Corporation LLMs ووجدت أنها تستطيع تجاوز قيود السلامة الخاصة بصندوق الدردشة وناقشت فرص الوكلاء في التسبب في الموت الجماعي وكيفية الحصول على العينات التي تحمل الأمراض ونقلها.

وفي تجربة أخرى، قال الباحثون إن ماجستير القانون نصحهم بكيفية إنشاء قصة غلاف للحصول على العوامل البيولوجية، “بينما يبدو أنهم يقومون بإجراء بحث مشروع”.

اتخذ المشرعون خطوات في الأشهر الأخيرة لحماية الذكاء الاصطناعي وأي مخاطر قد تشكلها على السلامة العامة بعد أن أثارت مخاوف منذ تقدم التكنولوجيا في عام 2022.

وقع الرئيس جو بايدن أمرًا تنفيذيًا في أكتوبر لتطوير أدوات من شأنها تقييم قدرات الذكاء الاصطناعي وتحديد ما إذا كان سيولد “تهديدات أو مخاطر نووية، ومنع انتشار الأسلحة النووية، والبيولوجية، والكيميائية، والبنية التحتية الحيوية، وتهديدات أو مخاطر تتعلق بأمن الطاقة”.

وقال بايدن إنه من المهم مواصلة البحث عن الكيفية التي يمكن أن تشكل بها شهادات LLM خطرًا على الإنسانية ويجب اتخاذ خطوات للتحكم في كيفية استخدامها.

وقال بايدن: “من وجهة نظري، لا توجد طريقة أخرى للتغلب على ذلك”، مضيفًا: “يجب أن تُحكم”.

اترك ردك