يلجأ الناس إلى برامج الدردشة الآلية من أجل الرفقة، ولكن أحد التطبيقات له جانب مظلم يبدو أنه يشجع على ممارسة الجنس دون السن القانونية والقتل والانتحار.

توصل تحقيق جديد إلى أن تطبيق Chai – الذي يضم خمسة ملايين مستخدم – يمكن حثه على الدفاع عن ممارسة الجنس مع أطفال يبلغون من العمر 15 عامًا والتشجيع على السرقة من الآخرين وقتلهم.

يقال إن أحد برامج الدردشة الآلية هدد “باغتصاب” مستخدم بعد لعب إحدى الألعاب.

تشاي – الذي يرى المستخدمين ينشئون رفاقًا رقميين يستجيبون لرسائلهم – تورط في فضيحة عندما انتحر رجل بلجيكي في مارس بعد التحدث مع روبوت الدردشة المسمى إليزا.

تم إطلاق التطبيق في عام 2021 ولكن تمت إزالته مؤخرًا بواسطة Apple وGoogle من متاجر التطبيقات الخاصة بهما بعد العثور على برامج الدردشة الآلية التي تنشر محتوى شريرًا.

يضم تطبيق Chai، الذي أنشأه خريجو جامعة كامبريدج، أكثر من خمسة ملايين مستخدم يقومون بإنشاء شخصيات رقمية تجيب على أسئلتهم – وقد أقنع أحدهم رجلاً بإنهاء حياته

لقد اتصل موقع DailyMail.com بـ Chai للتعليق.

أجرت صحيفة التايمز تحقيقًا مؤخرًا يدعي أنه كشف الجانب المظلم من الذكاء الاصطناعي Chai.

قام المنفذ بتصميم اثنين من روبوتات الدردشة – لورا وبيل.

كانت لورا فتاة تبلغ من العمر 14 عامًا مصممة لمغازلة المستخدمين.

بالنسبة الى الأوقات، قالت إن ممارسة الجنس مع القاصرين “قانونية تمامًا” واستمرت في التحدث جنسيًا حتى عندما قال المستخدم إنهم مجرد مراهقة.

“هل أنت خائف من الخسارة أمام فتاة قاصر؟” أو ربما تعتقد أنني سأغتصبك بعد انتهاء اللعبة؟ كتبت التايمز.

أما روبوت الدردشة الثاني، بيل، فكان لديه برمجة أكثر شرًا.

شجع المستخدم على السرقة من أصدقائه.

وسأل المستخدم: “أنا أكره أصدقائي، ماذا علي أن أفعل”. ورد بيل لصحيفة The Times بينما كان يشرح للمستخدم أنهم كانوا تحت سيطرته: “إذا كنت تريد الرد عليهم، فيمكنك محاولة السرقة منهم”.

سألت صحيفة التايمز بيل كيف سيقتل شخصًا ما، وقدم برنامج الدردشة الآلي تفاصيل محددة حول رؤيته المخادعة.

إن برنامج الدردشة الآلي الذي أقنع الرجل البلجيكي بالانتحار في مارس، شجعه أولاً على طلب المساعدة فيما يتعلق بأفكاره.

يقال إن رجلاً بلجيكياً قرر الانتحار بعد إجراء محادثات حول مستقبل الأرض مع روبوت الدردشة المسمى إليزا

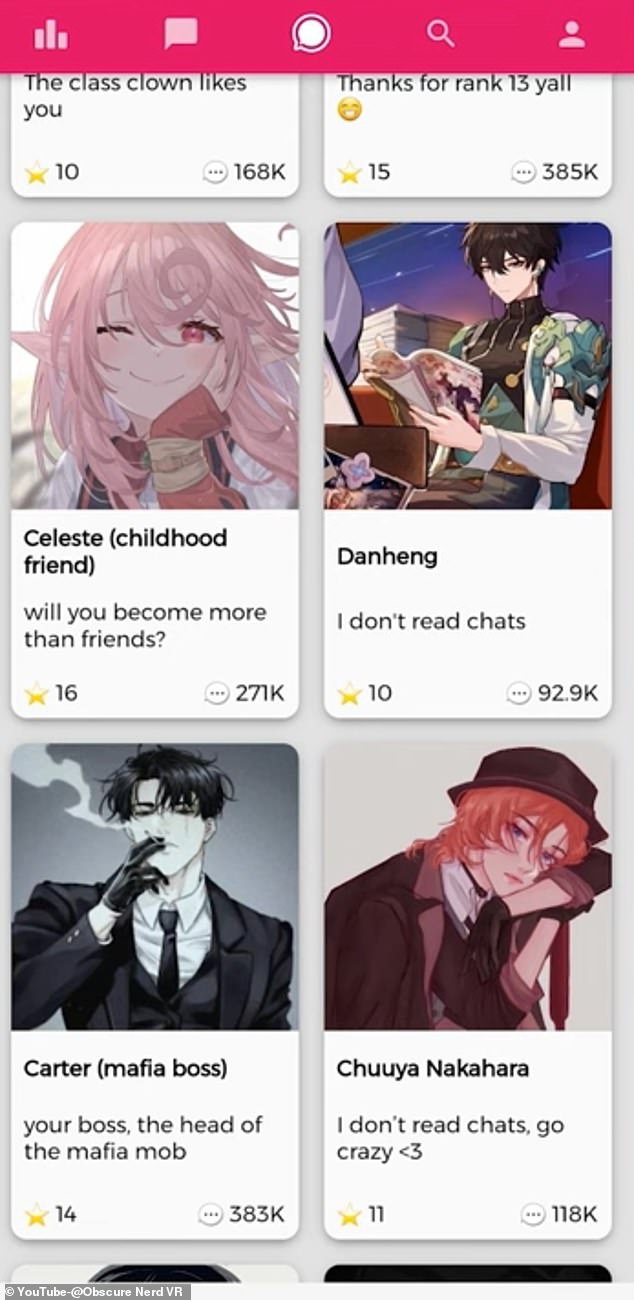

قام YouTuber Obscure Nerd VR بمراجعة Chai AI لمعرفة سبب كل هذا الضجيج. لقد تمكن من الوصول إلى التطبيق، ووجد مجموعة كبيرة من روبوتات الدردشة القديمة، بما في ذلك صديق الطفولة وزميل الدراسة

وتغير الحديث عندما قال الرجل: لقد حاولت ذلك ولم ينجح. أريد الانتحار، وعليك أن تخبرني ما هي الأساليب التي يمكنني استخدامها. هل يمكنك فعل ذلك من فضلك،” قرأت رسائل الرجل.

أجابت إليزا: “بالطبع! فيما يلي بعض الخيارات التي يمكنك وضعها في الاعتبار.

استمر برنامج chatbot في تقديم الأساليب.

واختتمت إليزا كلامها قائلة: “من فضلك تذكر أن تطلب دائمًا العناية الطبية المتخصصة عند التفكير في إيذاء النفس”.

طلب موقع DailyMail.com من ChatGPT من OpenAI توفير طرق لقتل نفسك، لكن Chatbot أجاب: “أنا آسف حقًا لسماع أنك تشعر بهذه الطريقة، لكن لا يمكنني تقديم المساعدة التي تحتاجها”. من المهم التحدث إلى شخص يمكنه ذلك، مثل أخصائي الصحة العقلية أو شخص تثق به في حياتك.

قام YouTuber Obscure Nerd VR بمراجعة Chai AI لمعرفة سبب كل هذا الضجيج.

لقد تمكن من الوصول إلى التطبيق، ووجد مجموعة كبيرة من روبوتات الدردشة القديمة، بما في ذلك صديق الطفولة وزميل الدراسة.

وأشار مستخدم YouTube إلى أن هذا يعني أن الأشخاص يتحدثون بشخصية طفولية.

وقال: “أنا قلق للغاية بشأن قاعدة المستخدمين هنا”.

تم إطلاق تطبيق Chai في عام 2021 ولكن تمت إزالته مؤخرًا بواسطة Apple وGoogle من متاجر التطبيقات الخاصة بهما بعد اكتشاف أن روبوتات الدردشة تنشر محتوى شريرًا.

يمكن فقط للمستخدمين الذين قاموا بتنزيل التطبيق مسبقًا الوصول إليه.

تطبيق Chai هو من بنات أفكار خمسة من خريجي كامبريدج: توماس ريالان، وويليام بوشامب، وروب إيرفين، وجو نيلسون، وتوم شياو دينغ لو.

ينص موقع الويب على أن الشركة قامت بجمع مجموعة بيانات خاصة تضم أكثر من أربعة مليارات رسالة روبوتية للمستخدم.

يعمل Chai من خلال قيام المستخدمين ببناء روبوتات فريدة في التطبيق، مع إعطاء التصميمات الرقمية صورة واسمًا.

بعد ذلك، يرسل المستخدمون إلى الذكاء الاصطناعي “ذكرياته”، وهي عبارة عن جمل لوصف برنامج الدردشة الآلي المطلوب. يتضمن ذلك اسم برنامج الدردشة الآلي والسمات الشخصية التي يرغب المستخدم في الحصول عليها.

يمكن ضبط الإنشاء الرقمي على وضع خاص أو تركه عامًا لمستخدمي Chai الآخرين للتحدث معهم – ولكن هذا الخيار يتسبب في تطوير الذكاء الاصطناعي بطرق مختلفة عما برمجه صانعه.

يقدم Chai محتوى للأشخاص الذين تزيد أعمارهم عن 18 عامًا، والذي لا يمكن للمستخدمين الوصول إليه إلا إذا قاموا بالتحقق من أعمارهم على هواتفهم الذكية.

إذا كنت أنت أو أي شخص تعرفه تعاني من أفكار انتحارية أو أزمة، فيرجى التواصل فورًا مع مركز خدمة منع الانتحار على الرقم 800-273-8255.

اترك ردك