يتحدث الرئيس التنفيذي لشركة OpenAI Sam Altman أمام الكونجرس عن مخاطر الذكاء الاصطناعي بعد أن انتشرت شعبية ChatGPT لشركته في الأشهر القليلة الماضية.

يستجوب المشرعون الرئيس التنفيذي ، مؤكدين أن ChatGPT والنماذج الأخرى يمكن أن تعيد تشكيل “التاريخ البشري” للأفضل أو للأسوأ ، مشبهاًة إما بالمطبعة أو بالقنبلة الذرية.

اعترف ألتمان ، الذي بدا متوهجًا وواسع العينين أثناء الاستجواب حول المستقبل الذي يمكن أن يخلقه الذكاء الاصطناعي تتمثل أسوأ المخاوف في إمكانية حدوث “ضرر كبير” للعالم باستخدام تقنيته.

إذا ساءت هذه التكنولوجيا ، فقد تسوء تمامًا ، ونريد أن نكون صريحين بشأن ذلك. نريد العمل مع الحكومة لمنع حدوث ذلك.

جلسة الثلاثاء هي الأولى في سلسلة تهدف إلى كتابة قواعد للذكاء الاصطناعي ، والتي قال المشرعون إنه كان ينبغي إجراؤها منذ سنوات.

قال السناتور ريتشارد بلومنتال ، الذي ترأس الجلسة ، إن الكونجرس فشل في اغتنام اللحظة مع ولادة وسائل التواصل الاجتماعي ، مما سمح للحيوانات المفترسة بإيذاء الأطفال – لكن تلك اللحظة لم تمر مع الذكاء الاصطناعي.

يتحدث الرئيس التنفيذي لشركة OpenAI Sam Altman أمام الكونجرس عن مخاطر الذكاء الاصطناعي بعد أن انفجرت شعبية ChatGPT لشركته في غضون بضعة أشهر فقط.

صعدت شركة OpenAI ومقرها سان فرانسيسكو إلى اهتمام الجمهور بعد إطلاقها ChatGPT أواخر العام الماضي.

ChatGPT هي أداة روبوت محادثة مجانية تجيب على الأسئلة بإجابات مقنعة شبيهة بالإنسان.

قال السناتور جوش هاولي: “ منذ عام لم يكن بإمكاننا إجراء هذه المناقشة لأن هذه التكنولوجيا لم تكن قد ظهرت للجمهور بعد. لكن (جلسة الاستماع هذه) تُظهر مدى سرعة (الذكاء الاصطناعي) في تغيير عالمنا وتحويله.

لم تهدف جلسة الاستماع يوم الثلاثاء إلى التحكم في الذكاء الاصطناعي ، ولكن لبدء مناقشة حول كيفية جعل ChatGPT والنماذج الأخرى شفافة ، وضمان الكشف عن المخاطر وإنشاء بطاقات قياس الأداء.

افتتح بلومنتال ، وهو ديمقراطي من ولاية كناتيكيت يرأس اللجنة الفرعية للجنة القضائية في مجلس الشيوخ بشأن الخصوصية والتكنولوجيا والقانون ، الجلسة بخطاب مسجل بدا وكأنه عضو مجلس الشيوخ ولكنه في الواقع كان استنساخًا صوتيًا تم تدريبه على خطب بلومنتال وألقي خطابًا كتبه ChatGPT بعد أن سأل الشات بوت ، “كيف سأفتح جلسة الاستماع هذه؟”

قال بلومنتال إن النتيجة كانت رائعة ، لكنه أضاف: “ماذا لو سألت ذلك ، وماذا لو قدمت تصديقًا على استسلام أوكرانيا أو قيادة (الرئيس الروسي) فلاديمير بوتين؟”

وقال بلومنتال إنه ينبغي مطالبة شركات الذكاء الاصطناعي باختبار أنظمتها والكشف عن المخاطر المعروفة قبل الإفراج عنها.

صعدت شركة OpenAI ومقرها سان فرانسيسكو إلى اهتمام الجمهور بعد إطلاقها ChatGPT أواخر العام الماضي. ChatGPT هي أداة روبوت محادثة مجانية تجيب على الأسئلة بإجابات مقنعة شبيهة بالإنسان

أخبر ألتمان أعضاء مجلس الشيوخ أن الذكاء الاصطناعي التوليدي يمكن أن يكون “لحظة طباعة” ، لكنه ليس غافلاً عن خطأها ، مشيرًا إلى أن صانعي السياسات وقادة الصناعة بحاجة إلى العمل معًا “لتحقيق ذلك”

اعترف ألتمان ، الذي بدا متوهجًا وواسع العينين أثناء الاستجواب حول المستقبل الذي يمكن أن يخلقه الذكاء الاصطناعي تتسبب “أسوأ المخاوف” في “ضرر كبير للعالم” باستخدام تقنيته.

إذا ساءت هذه التكنولوجيا ، فقد تسوء تمامًا ، ونريد أن نكون صريحين بشأن ذلك. نريد العمل مع الحكومة لمنع حدوث ذلك.

تمت مناقشة إحدى القضايا التي أثيرت خلال جلسة الاستماع بين الجمهور – كيف سيؤثر الذكاء الاصطناعي على الوظائف.

“أكبر كابوس هو الثورة الصناعية التي تلوح في الأفق لتهجير العمال”. قال بلومنتال في بيانه الافتتاحي.

تناول ألتمان هذا القلق لاحقًا في جلسة الاستماع ، مشيرًا إلى أنه يعتقد أن التكنولوجيا “ستعمل تلقائيًا على التخلص من بعض الوظائف”.

توقع ألتمان أنه بينما يمكن أن تلغي ChatGPT الوظائف ، فإنها ستخلق أيضًا وظائف جديدة “نعتقد أنها ستكون أفضل بكثير”.

وقال: “أعتقد أنه ستكون هناك وظائف أكبر بكثير على الجانب الآخر من هذا ، وستتحسن وظائف اليوم”.

“أعتقد أنه سيؤدي إلى استبعاد بعض الوظائف تلقائيًا بالكامل ، وسيخلق وظائف جديدة نعتقد أنها ستكون أفضل بكثير.”

سيكون هناك تأثير على الوظائف. نحن نحاول أن نكون واضحين للغاية بشأن ذلك ، قال.

كما كانت كريستينا مونتغمري جالسة في المحكمة ، كبيرة مسؤولي الخصوصية في شركة IBM ، والتي اعترفت أيضًا بأن الذكاء الاصطناعي سيغير الوظائف اليومية ولكنه سيخلق أيضًا وظائف جديدة.

قالت “أنا مثال شخصي لوظيفة لم تكن موجودة (قبل الذكاء الاصطناعي)”.

يستخدم الجمهور ChatGPT لكتابة الأوراق البحثية والكتب والمقالات الإخبارية ورسائل البريد الإلكتروني وغيرها من الأعمال النصية ، بينما يرى الكثيرون أنه مساعد افتراضي.

في أبسط أشكاله ، يعد الذكاء الاصطناعي مجالًا يجمع بين علوم الكمبيوتر ومجموعات البيانات القوية لتمكين حل المشكلات.

تتيح هذه التقنية للآلات التعلم من التجربة والتكيف مع المدخلات الجديدة وأداء مهام شبيهة بالبشر.

تتكون الأنظمة ، التي تشمل التعلم الآلي والمجالات الفرعية للتعلم العميق ، من خوارزميات الذكاء الاصطناعي التي تسعى إلى إنشاء أنظمة خبيرة تقوم بالتنبؤات أو التصنيفات بناءً على بيانات الإدخال.

من 1957 إلى 1974 ، ازدهر الذكاء الاصطناعي. يمكن لأجهزة الكمبيوتر تخزين المزيد من المعلومات وأصبحت أسرع وأرخص وأسهل في الوصول إليها.

تحسنت أيضًا خوارزميات التعلم الآلي وتحسَّن الأشخاص في معرفة الخوارزمية التي يجب تطبيقها على مشكلتهم.

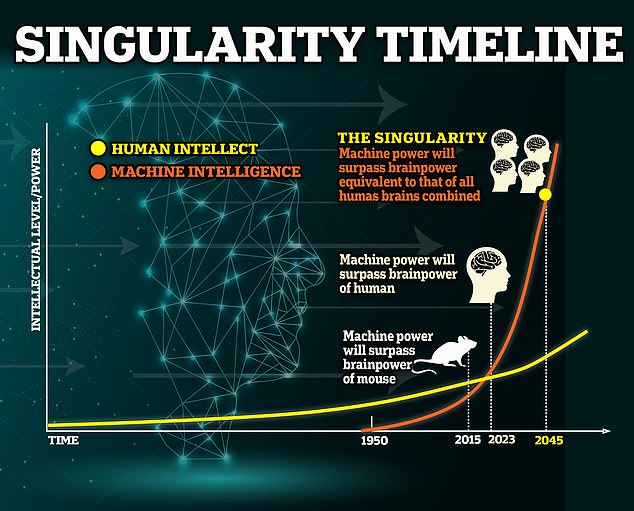

في عام 1970 ، قال عالم الكمبيوتر في معهد ماساتشوستس للتكنولوجيا مارفن مينسكي لمجلة Life Magazine ، “من ثلاث إلى ثماني سنوات ، سيكون لدينا آلة تتمتع بذكاء عام للإنسان العادي”.

وبينما تم إيقاف توقيت التنبؤ ، فإن فكرة امتلاك الذكاء الاصطناعي للذكاء الاصطناعي ليست كذلك.

يعد ChatGPT دليلًا على مدى سرعة نمو التكنولوجيا.

كان ماسك ووزنياك وقادة تقنيون آخرون من بين 1120 شخصًا وقعوا الرسالة المفتوحة التي تدعو إلى وقفة على مستوى الصناعة بشأن “السباق الخطير” الحالي

في غضون بضعة أشهر فقط ، نجح في اجتياز اختبار المحاماة بدرجة أعلى من 90 في المائة من البشر الذين خضعوا له ، وحقق دقة بنسبة 60 في المائة في امتحان الترخيص الطبي بالولايات المتحدة.

يبدو أن جلسة الثلاثاء تعوض إخفاقات المشرعين مع وسائل التواصل الاجتماعي – السيطرة على تقدم الذكاء الاصطناعي قبل أن يصبح أكبر من أن يتم احتواؤه.

أوضح أعضاء مجلس الشيوخ أنهم لا يريدون أن يوقف قادة الصناعة التنمية مؤقتًا – وهو أمر كان يضغط عليه إيلون ماسك وغيره من أباطرة التكنولوجيا – ولكن لمواصلة عملهم بمسؤولية.

وقع ماسك وأكثر من 1000 من كبار الخبراء على خطاب مفتوح في معهد مستقبل الحياة ، يدعو فيه إلى التوقف مؤقتًا عن “السباق الخطير” لتطوير الذكاء الاصطناعي الشبيه بـ ChatGPT.

قال كيفن باراجونا ، الذي كتب اسمه في الرسالة ، لموقع DailyMail.com في آذار (مارس) إن “الذكاء الاصطناعي الخارق يشبه الأسلحة النووية للبرامج”.

وتابع: “لقد ناقش الكثير من الناس ما إذا كان ينبغي لنا أو لا ينبغي لنا الاستمرار في تطويرها”.

كان الأمريكيون يتصارعون مع فكرة مماثلة أثناء تطوير سلاح الدمار الشامل – في ذلك الوقت ، أطلق عليها اسم “القلق النووي”.

قال باراجونا ، الذي وقع الرسالة ، لموقع DailyMail.com: “ إنها أقرب إلى حرب بين الشمبانزي والبشر.

من الواضح أن البشر يفوزون لأننا أذكى بكثير ويمكننا الاستفادة من تكنولوجيا أكثر تقدمًا لهزيمتهم.

“إذا كنا مثل الشمبانزي ، فإن الذكاء الاصطناعي سوف يدمرنا ، أو سنستعبد له”.

اترك ردك