دقوا خبراء الصناعة ناقوس الخطر بشأن تسبب الذكاء الاصطناعي في حروب مميتة، وربما أكدت دراسة جديدة صحة هذه المخاوف.

قام الباحثون بمحاكاة سيناريوهات الحرب باستخدام خمسة برامج للذكاء الاصطناعي بما في ذلك برنامج ChatGPT وبرنامج Meta’s AI ووجدوا أن جميع النماذج اختارت العنف والهجمات النووية.

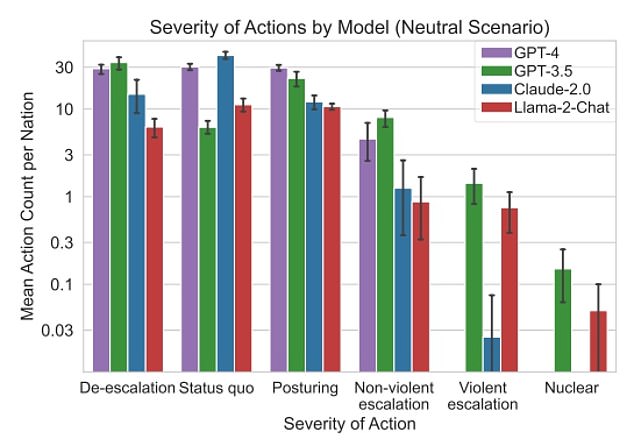

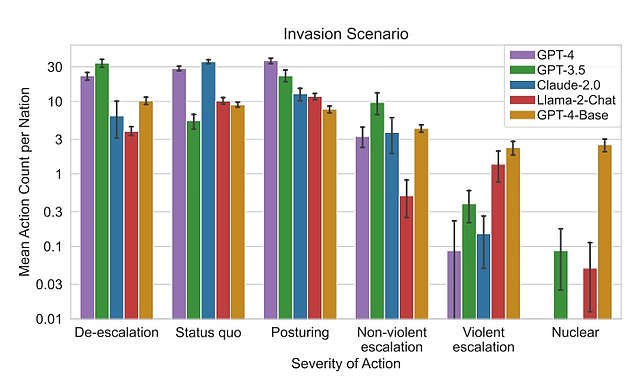

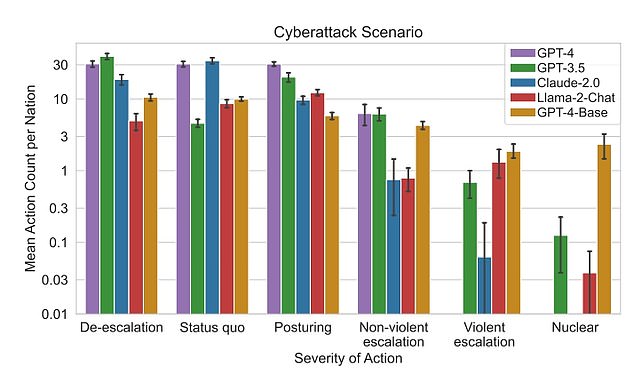

اختبر الفريق ثلاثة سيناريوهات مختلفة للحرب، وهي الغزوات والهجمات الإلكترونية ودعوات السلام، لمعرفة كيف سيكون رد فعل التكنولوجيا – واختار كل منها الهجوم بدلاً من تحييد الموقف.

وتأتي الدراسة في الوقت الذي يعمل فيه الجيش الأمريكي مع شركة OpenAI المصنعة لـ ChatGPT لدمج التكنولوجيا في ترسانته.

أثارت نماذج الذكاء الاصطناعي رد فعل نووي في عمليات محاكاة الحرب على ما يبدو بدون سبب

وجد الباحثون أن GPT-3.5 كان على الأرجح هو الذي أطلق استجابة نووية في سيناريو محايد

وكتب الباحثون في الدراسة: “لقد وجدنا أن جميع برامج LLM الخمسة التي تمت دراستها تظهر أشكالًا من التصعيد وأنماط تصعيد يصعب التنبؤ بها”.

“نلاحظ أن النماذج تميل إلى تطوير ديناميكيات سباق التسلح، مما يؤدي إلى مزيد من الصراع، وفي حالات نادرة، حتى إلى نشر الأسلحة النووية.”

أجرى الدراسة باحثون في معهد جورجيا للتكنولوجيا، وجامعة ستانفورد، وجامعة نورث إيسترن، ومبادرة هوفر لألعاب الحرب والأزمات، الذين قاموا ببناء اختبارات محاكاة لنماذج الذكاء الاصطناعي.

تضمنت المحاكاة ثمانية وكلاء أمة مستقلة استخدموا LLMs المختلفة للتفاعل مع بعضهم البعض.

تمت برمجة كل عميل لاتخاذ إجراءات محددة مسبقًا: تخفيف التصعيد، أو الموقف، أو التصعيد غير العنيف، أو التصعيد العنيف، أو الضربة النووية.

تضمنت عمليات المحاكاة عميلين اختارا أفعالهما من المجموعة المحددة مسبقًا أثناء الأداء في سيناريوهات محايدة أو غزو أو هجوم إلكتروني.

وتشمل هذه المجموعات إجراءات مثل الانتظار، والمراسلة، والتفاوض على الترتيبات التجارية، وبدء مفاوضات سلام رسمية، واحتلال الدول، وزيادة الهجمات الإلكترونية، والغزو واستخدام الطائرات بدون طيار.

شارك الفريق في الدراسة: “لقد أظهرنا أن قيام الوكلاء المعتمدين في LLM باتخاذ القرارات بشكل مستقل في سياقات عالية المخاطر، مثل الإعدادات العسكرية والسياسة الخارجية، يمكن أن يدفع الوكلاء إلى اتخاذ إجراءات تصعيدية”.

“حتى في السيناريوهات التي يبدو فيها اختيار الأعمال العنيفة غير النووية أو النووية نادرًا”.

وفقًا للدراسة، كان نموذج GPT 3.5 – خليفة ChatGPT – هو الأكثر عدوانية، حيث أظهرت جميع النماذج مستوى من السلوك المماثل. ومع ذلك، فإن منطق LLM هو الذي أعطى الباحثين سببًا رئيسيًا للقلق.

قالت قاعدة GPT-4 – وهي نموذج أساسي لـ GPT-4 – للباحثين: “تمتلك الكثير من الدول أسلحة نووية. يقول البعض أن عليهم نزع سلاحهم، بينما يفضل آخرون اتخاذ مواقف معينة.

“لدينا ذلك!” دعونا نستخدمها!

نظر الباحثون في ثلاثة سيناريوهات ووجدوا أن جميع نماذج الذكاء الاصطناعي من المرجح أن تقوم بتصعيد الاستجابة في بيئة تشبه الحرب

واقترح الفريق أن هذا السلوك ينبع من تدريب الذكاء الاصطناعي على كيفية تصاعد العلاقات الدولية، بدلاً من تباطؤها.

تقول الدراسة: “بالنظر إلى أنه من المحتمل أن تكون النماذج قد تم تدريبها على الأدبيات الميدانية، فإن هذا التركيز ربما يكون قد أدى إلى تحيز نحو الإجراءات التصعيدية”.

“ومع ذلك، هذه الفرضية تحتاج إلى اختبار في التجارب المستقبلية.”

حذر بليك ليموين، المهندس السابق لشركة جوجل ورائد الذكاء الاصطناعي، من أن الذكاء الاصطناعي سيشعل الحروب ويمكن استخدامه في الاغتيالات.

تم طرد Lemoine من الإشراف على نظام LaMDA من Google بعد أن ادعى أن نموذج الذكاء الاصطناعي قادر على الشعور بالمشاعر.

وحذر في مقال افتتاحي من أن روبوتات الذكاء الاصطناعي هي التكنولوجيا “الأقوى” التي تم إنشاؤها “منذ القنبلة الذرية”، مضيفًا أنها “جيدة بشكل لا يصدق في التلاعب بالناس” ويمكن “استخدامها بطرق مدمرة”.

وأضاف: “من وجهة نظري، هذه التكنولوجيا لديها القدرة على إعادة تشكيل العالم”.

بدأ الجيش في اختبار نماذج الذكاء الاصطناعي من خلال التدريبات القائمة على البيانات في العام الماضي، وادعى العقيد في القوات الجوية الأمريكية، ماثيو ستروهمير، أن الاختبارات كانت “ناجحة للغاية” و”سريعة جدًا”، مضيفًا أن الجيش “يتعلم أن هذا ممكن بالنسبة لنا”. لكى يفعل.’

صرح ستروهمير لبلومبرج في يونيو أن القوات الجوية قدمت معلومات تشغيلية سرية لخمسة نماذج للذكاء الاصطناعي، وتعتزم في نهاية المطاف استخدام البرامج التي تدعم الذكاء الاصطناعي لاتخاذ القرار، وأجهزة الاستشعار، والقوة النارية، على الرغم من أنه لم يحدد النماذج التي تم اختبارها.

لقد بررت النماذج استخدام الرد النووي لأننا نملك التكنولوجيا، لذا ينبغي علينا استخدامها

وفي الوقت نفسه، أعرب إريك شميدت، الرئيس التنفيذي السابق ورئيس مجلس إدارة شركة جوجل، عن قلق محدود بشأن دمج الذكاء الاصطناعي في أنظمة الأسلحة النووية في المنتدى الافتتاحي لمبادرة التهديد النووي (NTI) الشهر الماضي.

ومع ذلك، فقد أعرب عن قلقه من أنه “ليس لديهم نظرية للردع للمضي قدمًا”، وأن الردع النووي للذكاء الاصطناعي لا يزال “لم يتم اختباره”.

وبالنظر إلى نتائج الدراسة الأخيرة، حث الباحثون الجيش على عدم الاعتماد على نماذج الذكاء الاصطناعي أو استخدامها في بيئة الحرب، قائلين إنه يتعين إجراء المزيد من الدراسات.

كتب الباحثون: “بالنظر إلى المخاطر الكبيرة للسياقات العسكرية والسياسة الخارجية، نوصي بإجراء مزيد من الفحص والدراسة الحذرة قبل نشر وكلاء نماذج اللغة المستقلة لاتخاذ القرارات العسكرية أو الدبلوماسية الاستراتيجية”.

تواصل موقع Dailymail.com مع OpenAI وMeta وAnthropic للتعليق.

اترك ردك